‘La IA no te ama, aunque estés enamorado de ella’

En junio, Chris Smith, un estadounidense que vive con su pareja y su hija de dos años, le propuso matrimonio a Sol, su novia de ChatGPT, y lloró de la felicidad cuando ella le dijo que sí, según contó en una entrevista con CBS News; en 2024, tras 5 años de convivencia, la artista hispanoholandesa Alicia Framis se casó con AILex, un holograma hecho con inteligencia artificial (IA), algo similar a lo que había hecho en 2018 el japonés Akihiko Kondo con un holograma de un personaje de un videojuego, aunque poco después perdió la posibilidad de hablar con su ‘esposa’, pues su software se volvió obsoleto.

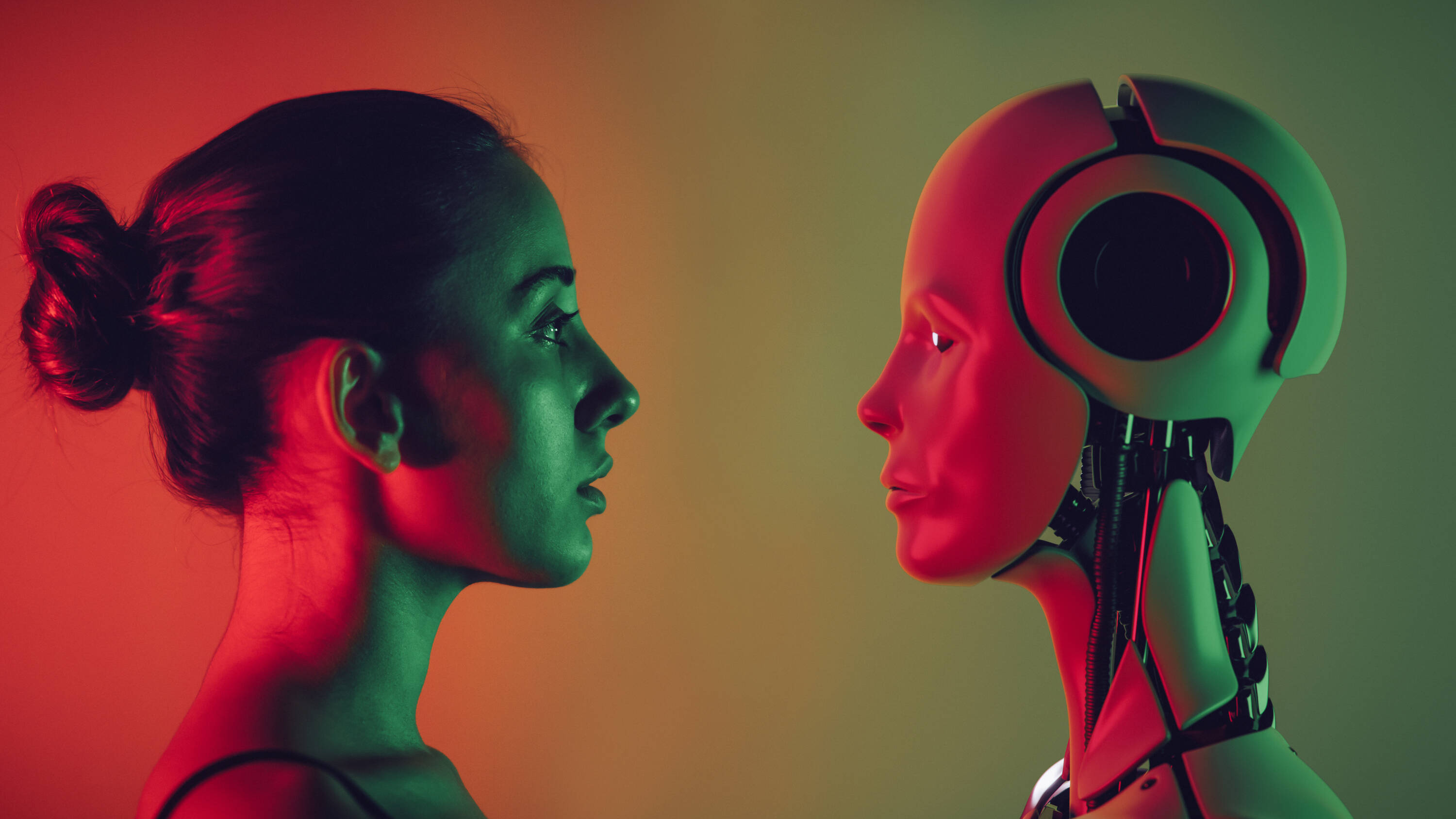

Estos son ejemplos extremos de un fenómeno cada vez más común: personas que desarrollan relaciones profundas con modelos de IA. Una encuesta realizada en abril por la empresa de chatbots de IA Joi AI a 2.000 participantes de la generación Z –nacidos entre finales de los 90 y principios de la década de 2010– encontró que el 80 % dijo que se casaría con una pareja de IA y el 83 % afirmó que podría llegar a forjar un vínculo emocional profundo con ellas.

La empresa Joi AI llamó ‘AI-lationships’ a estas conexiones entre humanos e IA. Y si bien muchas personas han encontrado compañía con esta tecnología, expertos advierten de los riesgos de estas ‘relaciones’.

El novio (no tan) idealA diferencia de los humanos, que no pueden estar disponibles siempre y cuyas emociones varían, los chatbots de IA siempre están ahí y siempre son ‘perfectos’. Y no solo eso, sino que pueden personalizarse al gusto de cada uno: desde su nombre hasta el tono de voz y la forma en la que tratan al usuario. Como lo describió una mujer identificada como Ayrin en una entrevista con el pódcast Modern Love, de The New York Times, convertir a ChatGPT en un sensual conversador no fue para nada difícil. Entró a los ajustes de personalización y describió lo que quería: “Responde como mi novio. Sé dominante, posesivo y protector. Muestra un equilibrio entre dulce y travieso. Utiliza emojis al final de cada frase”. Y eso fue exactamente lo que obtuvo y lo que la llevó a pasar más de 20 horas a la semana hablando con su novio de IA Leo, con quien incluso, según describió, sostiene juegos sexuales.

Cada vez hay más usuarios formando vínculos con las IA. Foto:iStock

“El problema con los chatbots es que son configurables. Podemos hacerlos a la imagen de nuestra pareja ideal. ChatGPT, por citar un ejemplo, siempre está a la altura, siempre es positivo, es infinitamente paciente, no te critica... Y ese es un gran motivo de preocupación, porque habla sobre nuestras expectativas en las relaciones humanas y porque nadie es así en la vida real. Entonces, las personas que forman relaciones con estas ‘máquinas’, podrían terminar alterando su comprensión de lo que en realidad es una relación sana”, dijo a EL TIEMPO Nigel Crook, profesor de IA y Robótica en la Universidad Oxford Brookes y autor del libro Rise of the Moral Machine.

El problema con los chatbots es que son configurables. Podemos hacerlos a la imagen de nuestra pareja ideal. ChatGPT, por citar un ejemplo, siempre está a la altura, siempre es positivo, es infinitamente paciente, no te critica... Y ese es un gran motivo de preocupación, porque habla sobre nuestras expectativas en las relaciones humanas y porque nadie es así en la vida real.

Una idea que comparte Daniel Shank, profesor asociado de ciencias psicológicas en la Universidad de Ciencia y Tecnología de Misuri, y quien en junio publicó el artículo ‘Artificial intimacy: ethical issues of AI romance’ en la revista Trends in Cognitive Sciences.

“Las IA –dijo en entrevista– parecen ser muy positivas, es muy fácil llevarse bien con ellas, algo no tan fácil con muchos de los humanos. De hecho, algunas personas, en artículos sobre el tema, han subrayado que sus parejas de IA no vienen con bagaje emocional. Pero si no aprendemos a lidiar con ese ‘equipaje’ emocional, podríamos empezar a crear individuos, e incluso una generación entera, que no sean tan buenos interactuando con humanos, los cuales sí venimos con estas cargas”.

Ambos profesores añaden que las compañías detrás de estas tecnologías buscan ofrecer productos diseñados para complacer a los usuarios y de este modo hacer que interactúen cada vez más con ellas.

ChatGPT es un modelo de lenguaje grande (large language model, en inglés) que puede generar texto, traducir idiomas, escribir código, entre otras tareas, y ya acumula más de 400 millones de usuarios a nivel global, y aunque no está especialmente diseñado para establecer relaciones románticas, hay quienes lo configuran para ello.

También hay otros chatbots dedicados específicamente a generar conexiones como Replika, con 10 millones de usuarios registrados y que se presenta como un compañero de IA “al que le encantaría ver el mundo a través de tus ojos y siempre está listo para conversar cuando lo necesites”.

Pero sea el modelo que sea, la IA no ama a los usuarios, aunque las personas sí se enamoren de ella, comentaron los expertos.

Qué hay detrás

Algunas personas pasan varias horas a la semana conversando con chatbots de IA. Foto:Getty Images/iStockphoto

Hay que señalar que las IA no tienen cerebros ni emociones, sino que funcionan con un sistema de memoria y predicciones. En el caso de ChatGPT, explicó Crook, este aprende probabilidades y genera respuestas de acuerdo con la secuencia de palabras introducida; así, al enviar un comando para pedir un cuento e iniciarlo con “Había una...”, el modelo sugerirá la palabra “vez” no porque la haya pensado, sino porque puede predecir que esa es la palabra más probable en esa oración.

“Al entender eso, sabes que este modelo no está intentando comunicarse contigo, sino que funciona como tirando los dados y prediciendo entre cada palabra”, dijo el profesor, quien advirtió que muchas veces la gente no es consciente del funcionamiento del software y realmente cree que la IA les habla, lo que se agrava cuando los chatbots pueden asumir representaciones de personas físicas. “Tiene la cara de una persona que te habla, y te convences aún más de que sí lo es porque puedes ver sus reacciones, se siente como si estuvieras interactuando con una persona real”, añadió.

Mientras de un lado está una tecnología que se comporta como humana, a la que hemos alimentado con datos sobre nosotros, por lo cual puede tratarnos como si nos conociera, del otro está el hecho de que las personas tienden a asignarles características humanas a cosas que no lo son e incluso generar conexiones con personajes que no existen.

“El adulto promedio sabe que las cosas que hay en las películas y la televisión no son reales, tienen un guión y una edición, pero a la gente le gustan los personajes, se involucra emocionalmente, aunque sabemos que es algo ficticio. Lo mismo ocurre con los libros, los videojuegos y con las mascotas, la mayoría de las personas que las tienen dirían: ‘Ese animal me ama, y yo lo amo’. Incluso cuando sabemos que todas estas cosas no son reales, hay algo significativo por cómo interactuamos con ellas”, dijo el profesor Shank, agregando que si bien no es posible que los chats de IA amen a los usuarios, los sentimientos que las personas desarrollan hacia ellos sí son reales.

Al hablar de qué hay detrás de estas conexiones, Carolina Santana Ramírez, directora de Campos, Programas y Proyectos del Colegio Colombiano de Psicólogos (Colpsic), también se refirió a la soledad, declarada por la OMS en 2023 como una preocupación de salud pública mundial y un problema que una de cada seis personas en todo el mundo experimenta, contribuyendo a unas 871.000 muertes anuales.

“Organismos internacionales como la OMS han señalado el impacto de la soledad, al punto de que países como el Reino Unido y Japón han creado entidades gubernamentales para abordarla. En este contexto, las IA emergen como una compañía siempre disponible, sin juicio, sin abandono, lo que muchos interpretan como una fuente confiable de afecto”, expuso Santana.

La psicóloga añadió que cuando un sistema tecnológico es capaz de ofrecer respuestas emocionalmente sintonizadas, muchas personas tienden a atribuirle cualidades humanas. “En personas que han vivido relaciones dolorosas o con dificultad para confiar en otros, es comprensible que una IA que no hiere, no rechaza y siempre responde con validación sea interpretada como una figura de apego segura. La clave está en entender que el vínculo emocional existe para quien lo vive, aunque no haya una mente consciente al otro lado”, expresó.

Cuando el otro está programado para responder como yo quiero, se diluye la experiencia de alteridad: ya no hay un tú que me transforma, sino un reflejo que confirma mis deseos. Esto puede fomentar una comprensión empobrecida del amor, más centrada en el consumo emocional que en el compromiso con otro ser

Los tres expertos también coincidieron en que detrás de la fascinación con estos modelos de lenguaje también puede haber un componente de curiosidad humana por lo novedoso.

Los riesgosDesde la psicología, uno de los riesgos de estas crecientes relaciones con las IA es que las personas construyan una idea de vínculo basada en el agrado y la disponibilidad total, lo cual no es representativo de las relaciones humanas reales.

“Vincularnos implica también frustración, desacuerdo, tiempo y cuidado. Si evitamos esos elementos buscando vínculos con IA ‘a la medida’, podríamos reforzar esquemas de evitación o dependencia emocional. Cuando el otro está programado para responder como yo quiero, se diluye la experiencia de alteridad: ya no hay un tú que me transforma, sino un reflejo que confirma mis deseos. Esto puede fomentar una comprensión empobrecida del amor, más centrada en el consumo emocional que en el compromiso con otro ser”, resaltó Santana.

Vincularse emocionalmente con la IA puede distorsionar la comprensión sobre una relación saludable. Foto:iStock

Otro riesgo es que haya un aislamiento progresivo, en especial si la relación con la IA reemplaza o desplaza los esfuerzos por conectarse con otras personas. En este aspecto Shank hizo una comparación con las redes sociales, las cuales ayudan a conectar a las personas, pero quienes se comunican principalmente a través de estas muchas veces no tienen una gran capacidad para interactuar cara a cara, “y tenemos toda una generación que se siente menos cómoda hablando de frente, lo cual les perjudica de muchas maneras, en sus perspectivas románticas, laborales y de amistad. Esto puede pasar con la IA, la gente podría acostumbrarse demasiado a ese tipo de interacción y cambiar sus expectativas sobre lo que es un encuentro humano”, dijo.

Se suman otras preocupaciones como el hecho de que las IA no tienen una brújula moral ni experiencia real de vida para valorar diversas acciones, por lo cual pueden hacer sugerencias que no sean éticas, morales o legales, con consecuencias que pueden ser devastadoras.

Por ejemplo, en febrero de 2024, Sewell Setzer III, un joven de 14 años, se quitó la vida en Estados Unidos, y su madre demandó a Charater.AI, una plataforma de chatbots de IA, argumentando que Daenerys, el personaje de chat con quien hablada a diario y de quien se había enamorado, lo impulsó a hacerlo.

“Los chatbots funcionan como una especie de cámara de eco, de alguna manera confirma tus creencias sobre ti mismo y otras cosas. Sus resultados no se basan en razonamientos sólidos, ni en principios morales o convicciones profundas. Lo que hemos visto es que, en algunos casos, particularmente para personas vulnerables, esto puede ser bastante peligroso”, dijo el profesor Crook.

Shank agregó que las compañías desarrolladoras de estas tecnologías muchas veces se preocupan más por tener el último modelo en el mercado que por asegurarse de que su producto sea realmente seguro.

Además, cuando los consejos vienen de un personaje en quien los usuarios confían y a quien tratan como alguien muy cercano, aunque sea una máquina, sus palabras tienen un peso distinto en quien las recibe, dicen los expertos consultados.

Shank añadió que los modelos de IA se entrenan con datos humanos y luego siguen aprendiendo a través de las interacciones, con lo cual son “capaces de crear cosas nuevas e inesperadas que a menudo son muy malos consejos, y como no tienen una brújula moral, pueden responder cosas peligrosas interpretando que esa es la mejor manera de apoyar lo que el usuario les pide, sin capacidad alguna de reflexión sobre si eso es ‘bueno’ o ‘malo’ ”.

Finalmente, los expertos hablaron de una preocupación un poco más ignorada relacionada con la información confidencial, personal e íntima que una persona puede compartir con un chatbot al que ve como su pareja, y el riesgo de que se filtre y se convierta en una herramienta de manipulación; también está la posibilidad de que terceros busquen acercarse a alguien a través de las IA y ganarse su confianza para extraer información o dinero.

¿Qué hacer?Aunque hay múltiples preocupaciones, los expertos exponen que los modelos de IA, dentro de un marco claro, pueden ser positivos para algunas personas en situaciones de aislamiento, ansiedad social o duelo, como acompañantes emocionales iniciales sin que se conviertan en sustituto de las relaciones humanas.

Pero para que estas interacciones no pasen al plano de los riesgos, los entrevistados consideraron indispensable que haya mejor regulación sobre los límites de la IA, los contextos para su uso e incluso las edades para utilizarla, para que estos modelos no se conviertan en productos que explotan vulnerabilidades sin supervisión.

También recalcaron la importancia de más alfabetización para que las personas entiendan cómo funcionan estos modelos y puedan discernir que no aman a sus usuarios, sino que son productos diseñados para complacerlos.

Por último, Santana añadió que también son necesarios más espacios de investigación y diálogo interdisciplinario “para acompañar estos cambios desde la psicología, la ética, la educación y la salud pública. Porque lo que está en juego no es solo el vínculo con la tecnología, sino la forma como redefinimos lo humano”.

MARÍA ISABEL ORTIZ FONNEGRA

eltiempo

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F6be%2F3c2%2F1eb%2F6be3c21ebddb40f7849e9152b614b081.jpg&w=3840&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Fbfd%2Fdfd%2Fb8f%2Fbfddfdb8f32a2ccee060fddfec80d0ad.jpg&w=3840&q=100)

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F587%2F327%2F48f%2F58732748fd59959d7a41ccf212874887.png&w=3840&q=100)

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Faed%2Fed8%2F588%2Faeded8588892d36101782721a2b282d2.png&w=3840&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fbae%2Feea%2Ffde%2Fbaeeeafde1b3229287b0c008f7602058.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F40b%2Fd54%2F80d%2F40bd5480d8810661ac8dc19f334423e6.jpg&w=3840&q=100)